Der EU AI Act erfordert die Unterscheidung von General-Purpose-AI-Modellen (GPAI) und GPAI-Systemen. Doch wie ist ein KI-Service wie „gpt-4o-search-preview“ einzuordnen? Was unterscheidet KI-Angebote mit Suchfunktion von ähnlich klingenden KI-Services wie „gpt-5“? Beide Varianten sind über eine API zugänglich, können aber in rechtlicher Hinsicht entscheidende Unterschiede besitzen.

Wichtiger Hinweis: Über die in diesem Artikel genannten Services hinaus gibt es eine Vielzahl vergleichbarer Services anderer Anbieter*. Der Fokus auf den KI-Services „gpt-5“ und „gpt-4o-search-preview“ ist exemplarisch zu verstehen.

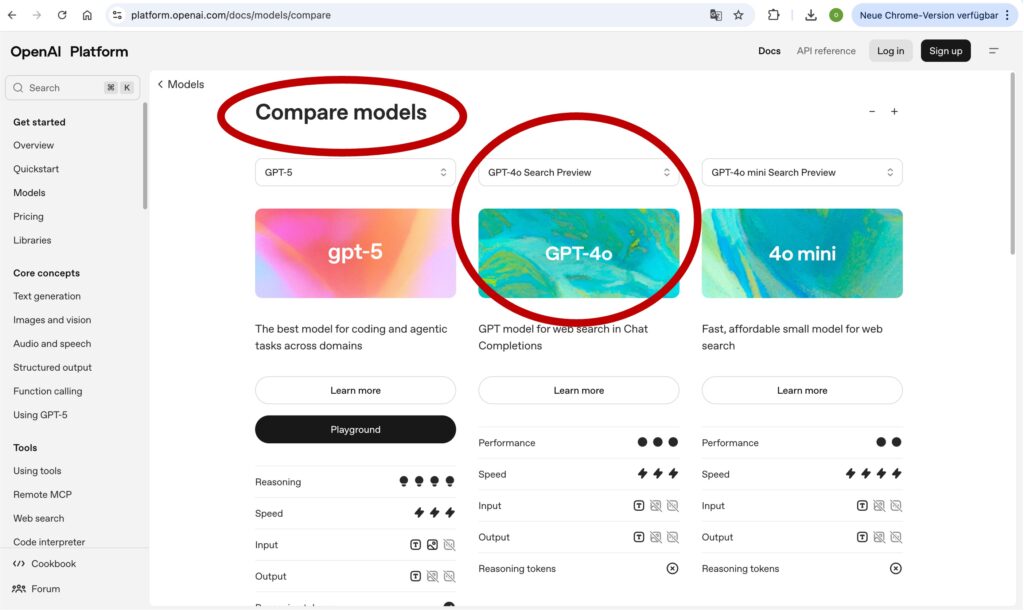

Abbildung 1: OpenAI bezeichnet seine KI-Services allesamt als „KI-Modell“. Im Sinne der KI-Verordnung sind es aber nicht nur KI-Modelle, sondern auch KI-Systeme, die mittels APIs angeboten werden! Das Angebot „GPT-4o-search-preview“ (Mitte) ist beispielsweise ein „KI-System mit allgemeinem Verwendungszweck“. Ausgeliefert als Remote-Service. Es fällt damit Art. 3 Nr. 66 EU AI Act und nicht unter Art. 3 Nr. 63 EU AI Act. Anders: Der Service GPT-5 (links). Hier handelt es sich (mit großer Wahrscheinlichkeit) um ein GPAI-Modell i.S.v. Art. 3 Nr. 63 EU AI Act. https://platform.openai.com/docs/models/compare

Was ist ein GPAI-Modell?

Unter GPAI-Modellen versteht man KI-Modelle mit allgemeinem Verwendungszweck im Sinne von Art. 3 Nr. 63 EU AI Act. Sie sind der Grundbaustein für generative künstliche Intelligenz. Es handelt sich um große Sprachmodelle (Large Language Model, LLM), die mit unzähligen Daten trainiert wurden und eine Vielzahl von Aufgaben mit hoher Kompetenz bewältigen können.

- KI-Modelle sind das „Gehirn“ eines KI-Systems, das Informationen generiert, versteht und mit ihnen argumentiert. Es agiert allein auf Basis der Daten, mit denen es trainiert wurde.

- Das KI-System (Art. 3 Nr. 1 EU AI Act) entspricht dem physischen und operativen „Körper“ einer KI. Viele KI-Systeme zeichnen sich durch Interaktionsmöglichkeiten mit Nutzern aus. So ist beispielsweise ein Chatbot als KI-System zu bewerten.

- Wird ein KI-Modell mit allgemeinem Verwendungszweck in ein KI-System integriert, entsteht automatisch die Sonderform des KI-Systems mit allgemeinem Verwendungszweck, Art. 3 Nr. 66 EU AI Act.

GPAI-Systeme und GPAI-Modelle sind mitunter schwer unterscheidbar. Vor allem dann, wenn sie remote als Service angeboten werden. Rechtlich bestehen jedoch wichtige Unterschiede.

Wie werden GPAI-Modelle integriert?

Generative GPAI-Modelle sind explizit dafür gedacht, dass sie in KI-Systeme integriert werden. Die Integration kann auf unterschiedliche Art erfolgen. Die beiden folgenden Varianten sind dabei zu unterscheiden:

- Lokale Integration: GPAI-Modelle wie Llama (von Meta) oder Qwen (von Alibaba) können auf Plattformen wie Hugginface downgeloaded und auf dem privaten Computer betrieben werden. Mit speziellen Tools wie Ollama können sie über Schnittstellen in eigene KI-Systeme oder fertige Chat-Applikationen wie GPT4all integriert und dadurch auch offline genutzt werden.

- Remote-Integration: Alternativ können GPAI-Modelle auch über das Internet als Model as a Service „remote“ bereitgestellt werden. Entweder auf einem eigenen Server, also via VPS (Virtual private Server). Alternativ durch Anbieter wie Anthropic, Groq oder Google Gemini. Sie bieten diverse GPAI-Modelle über Schnittstellen an (APIs).

Für die Nutzung ist der remote-Services ist ein individueller Schlüssel, ein so genannter API-Key, erforderlich. Viele API-basierte KI-Services sind im Rahmen bestimmter Kontingente kostenlos. Bei großen Anbietern wie OpenAI ist die Anbindung der GPAI-Modelle aber in der Regel kostenpflichtig. Diese Variante funktioniert nur bei laufender Internetverbindung, also nur online und nicht offline.

Es macht in rechtlicher Hinsicht grundsätzlich keinen Unterschied, auf welche der beiden Varianten man zurückgreift, um ein GPAI-Modell zu integrieren. Beide sind gleichwertig und ermöglichen die Integration des GPAI-Modells in ein übergeordnetes KI-System.

| Integration | lokal | remote |

|---|---|---|

| Typ | auf eigenem Computer via localhost oder Plattformen wie Ollama | via Internet (als kostenloser oder kostenpflichter Service) |

| Offline Nutzung | ✅ | ❌ |

| API-Key erforderlich | ✅ / ❌ | ✅ |

Was sind die rechtlichen Wirkungen?

Im Fall beider Varianten der Integration entstehen zwei rechtlich relevante Wirkungen:

- Der Anbieter des KI-Systems wird zum „nachgelagerten Anbieter“ im Sinne von Art. 3 Nr. 68 EU AI Act, sobald ein GPAI-Modell integriert wird. Dadurch entstehen erweiterte Rechte gegenüber dem Anbieter des GPAI-Modells, vorausgesetzt, beide Akteure erfüllen als Anbieter die Voraussetzungen von Art. 3 Nr. 3 EU AI Act.

- Das KI-System selbst wird durch die Integration eines GPAI-Modells zudem zu einem GPAI-System im Sinne von Art. 3 Nr. 66 EU AI Act. Durch die Integration ist das KI-System nunmehr seinerseits in der Lage, eine Vielzahl von Aufgaben mit hoher Kompetenz zu erfüllen.

| Anbieter-Typen | KI-System | GPAI-Modell |

|---|---|---|

| Beschreibung | Bietet ein KI-System i.S.v. Art. 3 Nr. 1 an. Ist Anbieter nach Art. 3 Nr. 3 Variante 1 EU AI Act. | Bietet ein GPAI-Modell i.S.v. Art. 3 Nr. 63 an. Ist Anbieter nach Art. 3 Nr. 3 Variante 2 EU AI Act. |

| nachgelagerter Anbieter | kann zum nachgelagerten Anbieter des GPAI-Modells werden (rechtes Spalte), Art. 3 Nr. 68 EU AI Act | hat Pflichten gegenüber nachgelagerten Anbietern (linke Spalte), u.a. Art. 53 (1) EU AI Act i.V.m. Anhang XII |

| API-Key erforderlich | ✅ / ❌ | ✅ |

Der nachgelagerte Anbieter wird nachfolgend kurz skizziert. Anschließend wird der Unterschied zwischen den ähnlich klingenden API-Services „gpt-4o“ und „gpt-4o-search-preview“ beleuchtet.

Was ist ein nachgelagerter Anbieter?

Die Erweiterung vom Anbieter eines KI-Systems zum nachgelagerten Anbieter des GPAI-Modells ist wichtig, da letzterer das Recht erhält, wichtige Informationen über das GPAI-Modell zu erhalten. Diese Rechte sind in Art. 53 Abs. 1 Buchst. b EU AI Act und Anhang XII geregelt. Anbieter von KI-Systemen benötigen zentrale Informationen zu den darin genutzten KI-Modellen, um ihrerseits ihre Pflichten gegenüber den Aufsichtsbehörden als auch innerhalb von KI-Wertschöpfungsketten nachkommen zu können.

Nachgelagerter Anbieter kann daher nur ein Anbieter eines KI-Systems sein, in das ein GPAI-Modell integriert ist. Egal ob lokal oder remote! Nur dann bestehen Ansprüche gemäß Art. 53 (1) EU AI Act i.V.m. Anhang XII!

Was ist ein GPAI-System?

Ein GPAI-System ist ein besonderes KI-System. in das ein GPAI-Modell integriert wurde. Ein GPAI-System kann daher in vielseitiger Form verwendet werden und seinerseits in andere KI-Systeme integriert werden (vgl. Definition in Art. 3 Nr. 66 EU AI Act). Art. 3 Nr. 68 EU AI Act stellt klar, dass auch Anbieter eines GPAI-Systems als nachgelagerte Anbieter gelten und somit Transparenzansprüche besitzen.

Zunächst zum Vergleich von KI-System und GPAI-System:

| KI-System-Typen | KI-System | GPAI-System |

|---|---|---|

| Definition | Legaldefinition ist in 3 Nr. 1 EU AI Act. | Sonderfall des KI-Systems: Legaldefinition ist in 3 Nr. 66 EU AI Act. |

| verwendetes KI-Modell | kann alle Arten von KI-Modellen verwenden | verwendet KI-Modell mit allgemeinem Verwendungszweck i.S.v. Art. 3 Nr. 63 EU AI Act |

| Integration in andere KI-Systeme | ✅ | ✅ |

| Pflichten gemäß Art. 53 (1) | ❌ | ❌ |

Welche Unterschiede bestehen?

Beide GPAI-Varianten können als „AI as a Service“ in KI-Systeme integriert werden:

- GPAI-Modelle „as a Service“ im Sinne von Art. 3 Nr. 63 EU AI Act.

- GPAI-Systeme „as a Service“ im Sinne von Art.3 Nr. 66 EU AI Act.

Aber: Die Rechte aus der nachgelagerten Anbieterschaft gibt es nur im ersten Fall – also der Integration von GPAI-Modellen! Das ist es, was die Unterscheidung von KI-Services, die remote angeboten werden, so wichtig macht!

| GPAI-Typen | GPAI-Modell | GPAI-System |

|---|---|---|

| Definition | Legaldefinition ist in 3 Nr. 63 EU AI Act. | Legaldefinition ist in 3 Nr. 66 EU AI Act. |

| verwendetes KI-Modell | ist selbst das GPAI-Modell | verwendet KI-Modell mit allgemeinem Verwendungszweck i.S.v. Art. 3 Nr. 63 EU AI Act |

| Integration in andere KI-Systeme | ✅ | ✅ |

| eigenständige Nutzung durch Betreiber | nein, keine eigenständige Nutzung ohne Integration in ein KI-System | kann direkt eingesetzt oder in andere KI-Systeme integriert werden, vgl. Gründe 100 |

| Pflichten gemäß Art. 53 (1) | ✅ | ❌ |

Was bedeutet „augmented“?

Somit zur Frage, welchen rechtlichen Unterschied es macht , wenn man als Anbieter eines KI-Systems einen API-basierten Remote-Service wie:

- „gpt-5“ bzw. „gpt-4o“ oder alternativ

- “gpt-4o-search-preview” integriert?

Kurz gesagt: Der erste Service ist eine sogenannte „non-augmented-response“. Der zweite Service ist eine „search augmented response“. Diese ist wiederum ein Unterfall der „retrieval augmented generation“ (RAG). RAG-Systeme sind aber keine KI-Modelle, sondern eine Technik bzw. ein Verfahren, um die Outputs durch erweitete Daten-Anbindung zu optimieren. Insofern ist die auf den Websites von OpenAI gewählte Formulierung, dass es sich bei „gpt-4o-search-preview“ um ein besonderes „KI-Modell“ handelt, mit Vorsicht zu genießen.

| Service-Typus | non-augmented | augmented |

|---|---|---|

| Schwerpunkt | Liefert ausschließlich Zugriff auf das GPAI-Modell | Liefert Zugriff auf GPAI-Modell plus weiteren Services |

| KI-Typus i.S.d. KI-Verordnung | GPAI-Modell (Art. 3 Nr. 63 EU AI Act) | GPAI-System (Art. 3 Nr. 66 EU AI Act) |

| Add ons | ❌ | z.B. Internet-Suche, RAG-Services für Dateien, Agenten |

Zwischenfazit:

- Nur die Services „gpt-5“ bzw. „gpt-4o“ sind GPAI-Modelle.

- “gpt-4o-search-preview” ist hingegen ein GPAI-System.

- Beide sind remote mit dem gleichem API-Key integrierbar.

- Aber nur im ersten Fall gibt es nachgelagerte Anbieter.

- Nur im ersten Fall greift Art. 53 (1) EU AI Act.

In den USA werden beide Varianten als „KI-Modell“ bezeichnet. Dies ist möglich, da dort die KI-Verordnung nicht gilt. Bei der Nutzung innerhalb der EU ist der Unterschied jedoch relevant!

Welcher Service wird geliefert?

Wichtig ist: Ein API-basierter Remote-Service für KI kann in tatsächlicher und rechtlicher Hinsicht unterschiedlich ausfallen:

- Der Standard-Fall: Wer den Service „gpt-4o“ nutzt, ist unmittelbar an das GPAI-Modell selbst angeschlossen. Daher auch der Begriff „non-augmented“. Das Wort „augmented“ bedeutet so viel wie „verstärkt“. Ein einfacher Test zeigt, dass diese Variante stets über einen finalen Trainingszeitpunkt verfügt: Den sogenannten „knowledge-cut-off“. Auf die Frage nach dem US-Präsidenten dürfte „gpt-4o“ bis in alle Ewigkeit antworten: „Joe Biden“. Das Modell verfügt nämlich nur über Daten, die vor der Wahl von Donald Trump eintrainiert wurden.

- Der verstärkte Fall: Ganz anders beim API-Aufruf des Service „gpt-4o-search-preview“. Dieser Service ist „augmented“, also „verstärkt“. Er berücksichtigt nicht nur das Wissen des KI-Modells, sondern zusätzlich Echtzeitinformationen jenseits der Trainingsdaten des GPAI-Modells. Die Antwort ist eine Kombination aus dem Output des GPAI-Modells und den Ergebnissen einer externen, maschinellen Echtzeitsuche.

Die operative Konsequenz: Auf die exakt gleiche Frage nach dem US-Präsidenten würde der verstärkte KI-Service mit „Donald Trump“ antworten, obwohl auch bei diesem Service das exakt gleiche KI-Modell wie bei der ersten Variante angebunden ist. Die Konsequenz: Der API-Service „gpt-4o-search-preview“ ist – ebenso wie alle anderen RAG-Services – ein KI-System as a Service. Allerdings eines, das vor der Antwort das Internet maschinell durchsucht und dann eine kombinierte Antwort liefert, die aus den Suchergebnissen und der Interpretation dieser Ergebnisse durch das GPAI-Modell entsteht.

Die rechtliche Konsequenz: Das Zusammenspiel verschiedener Komponenten (Suche und Interpretation) macht den Such-Service zu einem GPAI-System im Sinne von Art. 3 Nr. 66 EU AI Act. Für diesen bestehen keine Pflichten gegenüber nachgelagerten Anbietern, die den Service in ihre KI-Systeme integrieren.

Was ist bei Fundstellen?

Der Output der Anfrage bei Variante zwei, also bei „gpt-4o-search-preview“ erfolgt in der Regel zusammen mit einer Link-Sammlung der Quellen, die bei der Antwortfindung berücksichtigt wurde. Diese Fundstellen können dann über einen Browser aufgerufen und geprüft werden – vorausgesetzt, die Verlinkungen existieren tatsächlich. Hier liegt ein häufig unbemerktes Problem: Nicht jeder in einer Antwort angezeigte Link existiert tatsächlich. Und nicht jede Antwort eines AI-Search-Services ist folglich valide: Es gibt auch „Link-Halluzinationen“. Vor allem dann, wenn der angezeigte Link nicht (mehr) existiert.

Die Konsequenz ist, dass ein API-Suchservice nicht nur ein KI-System ist. Es ist zudem eines, das in mehrfacher Hinsicht halluzinieren kann:

- Im Hinblick auf den Link.

- Als auch dessen Inhalte.

- Und damit auf die gesamte Antwort.

Die besondere Tücke: Bereits durch die bloße Anzeige von vermeintlichen Quellen wirken die Antworten einer KI glaubwürdiger. Man vertraut als Nutzer, ohne das Angebot tatsächlich zu validieren. Dadurch werden falsche Antworten potenziell noch irreführender – und somit noch kritischer für den, der einen verstärkten KI-Service in seine eigenen KI-Systeme integriert.

Wie ist es bei KI-Agenten?

So genannte „Reasoning-Modelle“ verfügen über erweiterte Fähigkeiten, um Entscheidungen nachvollziehbar zu machen. Ein solches Modell ist z.B. das gpt-o3. Obwohl solche Modelle intern einen sehr komplexen und mehrstufigen Denkprozess (= Reasoning) durchführen, bleibt der Prozess eine rein interne Eigenschaft des Modells. Dies gilt so lange wie keine weiteren Tools genutzt werden, um Aufgaben zu erfüllen. Erst wenn der Service mit externen Komponenten verknüpft wird (wie im Fall von gpt-o3-deep-research), ändert sich die Klassifizierung.

Anders, wenn „fertige“ Agenten-Services ausgeliefert werden. Dann handelt es sich in aller Regel um KI-Systeme bzw. GPAI-Systeme.

Was ist ein KI-System-Service?

Zusammenfassend lassen sich die unterschiedlichen Remote-Services grob wie folgt einteilen:

a) Reine KI-Modell-Services (GPAI-Modelle as a Service):

- Image generation: Erzeugt bei OpenAI Bilder basierend auf dem internen DALL·E-Modell.

- Text to speech / Speech to text: Konvertiert Audio/Text ausschließlich mit den internen Algorithmen der Modelle (wie Whisper).

- Embeddings / Moderation: Erzeugt Vektordarstellungen oder bewertet Inhalte, ohne externe Daten zu benötigen.

- GPT-5, o3 (Reasoning-Kategorie), GPT-4o: Diese werden als Modelle bereitgestellt, die auf Nutzereingaben basieren.

b) Erweiterte KI-System-Services (GPAI-Systeme as a Service):

- Agent internet access: Bietet dem Modell die Fähigkeit, selbstständig auf das Internet zuzugreifen, um Informationen zu sammeln.

- gpt-4o-search-preview: Integriert das Modell mit einer Websuchfunktion, die es ihm ermöglicht, Suchergebnisse zu verarbeiten und in die Antwort einzubeziehen.

- o3-deep-research: Ähnlich wie der

search-previewService orchestriert dieser Dienst die Suche und Synthese von Informationen, was über die reine Modellinferenz hinausgeht.

Welche Konsequenzen entstehen?

Um es noch einmal zu betonen: Ein API-Service wie „gpt-4o-search-preview“ ist, anders als der reine API-Zugriff auf das Basismodell, ein KI-System. Die Nutzung eines reinen GPAI-Modells erfordert daher auch andere Überlegungen als die Integration eines kompletten Systems mit diversen, oft schwer durchschaubaren Funktionalitäten, die zusätzliche Risiken in Bezug auf Datenintegrität und Richtigkeit der Informationen mit sich bringen:

- Wer den Service „gpt-4o-search-preview“ nutzt, wird nicht zum „nachgelagerten Anbieter“ im Sinne von Art. 3 Nr. 68 EU AI Act, weil kein KI-Modell, sondern ein KI-System integriert wird. Folglich gibt es auch keinen Anspruch aus Art. 53 Abs. 1 EU AI Act i.V.m. Anhang XII gegen den Anbieter des Services.

- Ein weiteres Problem betrifft die Frage der Gewährleistung oder deliktischen Haftung für die Ausgaben des eigenen KI-Systems:

- Wer einen API-basierten Search-Service in das eigene KI-System integriert, hat den Vorteil, Echtzeit-Informationen berücksichtigen zu können.

- Durch die Verstärkung entfallen jedoch die Rechte der nachgelagerten Anbieterschaft, da diese nur dann bestehen, wenn ein GPAI-Modell und nicht ein GPAI-System integriert wird.

- Zugleich wird der vom Service ausgegebene Inhalt noch unberechenbarer, da der Output in wesentlicher Form durch die „Verstärkung“ beeinflusst ist. So trifft das mittels API angebundene KI-System selbstständig die Entscheidung, welche Suchergebnisse es berücksichtigt und welche nicht.

Fazit:

KI-Remote-Services können nauf den ersten Blick sehr ähnlich wirken. Erst recht, wenn die Service-Beschreibungen im Sinne der KI-Verordnung rechtlich nicht differenzieren. So werden bei OpenAI (wie auch bei anderen Anbietern) GPAI-Modell-Services und GPAI-System-Services gleichermaßen als „KI-Modelle“ bezeichnet.

Das ist nicht immer korrekt!

So können remote-Services wie „gpt-4o-search-preview“ fälschlich als GPAI-Modell wahrgenommen werden, obwohl es sich um einen GPAI-System-Service handelt. Bei Reasoning-Services besteht in dieser Hinsicht auch ein rechtlicher Graubereich, bei dem jeder einzelne Service individuell beurteilt werden muss, ob und wie weit es sich tatsächlich um ein GPAI-Modell oder ein GPAI-System handelt.

Abschließend folgende Übersicht – exemplarisch am Beispiel von gpt-4o und gpt-4o-search-preview:

| Merkmal | gpt-5 / gpt-4o | gpt-4o-search-preview |

|---|---|---|

| Typ | GPAI-Modell (Art. 3 Nr. 63) | GPAI-System (Art. 3 Nr. 66) |

| Datenquelle | Modellintern (nur Trainingsdaten) | Modell + Echtzeitsuche |

| nachgelagerte Anbieterschaft Art. 3 Nr. 68 | ✅ | ❌ |

| Rechte nach Art. 53 | ✅ | ❌ |

| Transparenz durch Anbieterpflichten | ✅ | ❌ |

| erhöhte Überzeugungskraft ggü. Nutzern | mittel | erhöht durch Integration von (realen?) Quellen |

| Risiko unvorhersehbarer Antworten | nur abhängig von KI-Modell | auch abhängig von Suchergebnissen |

In rechtlicher Hinsicht ist die Bezeichnung als „KI-Modell“ auf den Seiten von OpenAI zulässig, da es jedem Anbieter frei steht, die Begriffe zu wählen, die aus eigener Sicht zutreffend sind. Außerhalb der EU ist die Bezeichnung von „gpt-4o-search-preview“ als KI-Modell auch unproblematisch. Es ändert aber nichts daran, dass der Service im Geltungsbereich der KI-Verordnung mit hoher Wahrscheinlichkeit als „KI-System“ i.S.v. Art. 3 Nr. 1 EU AI Act bzw. „GPAI-System“ i.S.v. von Art. 3 Nr. 66 EU AI Act zu bewerten ist.

Beim Anbinden von „verstärkten“ KI-Services ist folglich darauf zu achten, ob es sich um sogenannte „non-augmented-services“ handelt oder nicht. Ansprüche als nachgelagerter Anbieter bestehen nur dann, wenn ausschließlich ein GPAI-Modell über einen API-Key integriert wird. Ein Service wie „gpt-4o“ erfüllt diese Voraussetzung. Ein Mehrwert-Service wie „gpt-4o-search-preview“ tut dies hingegen nicht.

Zugleich ist zu beachten, dass Antworten von „verstärkten“ KI-Services nicht besser und richtiger sein müssen. Dennoch können sie eine gesteigerte Überzeugungskraft besitzen. Im Falle falscher Antworten kann dies im Hinblick auf die Verletzung von allgemeinen Sorgfaltspflichten für Anbieter von KI-Systemen von Bedeutung sein!

Bezug zum Skript „Grundwissen-KI-Recht“ u.a.: RN 15, 103, 110, 407

Inhalte des Beitrags, u.a.:

- KI-System, Art. 3 Nr. 1 EU AI Act

- KI-Modell mit allgemeinem Verwendungszweck, Art. 3 Nr. 63 EU AI Act

- KI-System mit allgemeinem Verwendungszweck, Art. 3 Nr. 66 EU AI Act

- nachgelagerte Anbieterschaft, Art. 3 Nr. 3, 68 & Art. 53 EU AI Act

- Remote AI Services

* Aus Gründen der besseren Lesbarkeit wird im Text die männliche Form verwendet, die weibliche Form ist selbstverständlich immer mit eingeschlossen.