Neuste Veröffentlichung belegen: Mittels manipulierter Kalendereinladungen und manipulierten Dokumenten konnten KI-Agenten dazu gebracht werden, sensible Daten preiszugeben oder gar Geräte im Smart Home zu steuern. Das ist kein bloßes Security-Szenario mehr — es ist auch eine immer wichtiger werdende rechtliche Baustelle!

Worum geht es?

In einem LinkedIn-Beitrag weist der Hamburger KI und Security-Experte Christian Bennefeld auf neue, nachgewiesene Gefahren von KI-Agenten hin – hier u.a. das unautorisierte Manipulieren von Smart Home Geräten auf Basis von Kalendereinträgen:

Was sagt Christian Bennefeld?

Der Wortlaut des Beitrags von Christian Bennefeld wird an dieser Stelle unkommentiert wiedergegeben. Jeder Leser kann und sollte sich zunächst selbst Gedanken seinen Aussagen machen:

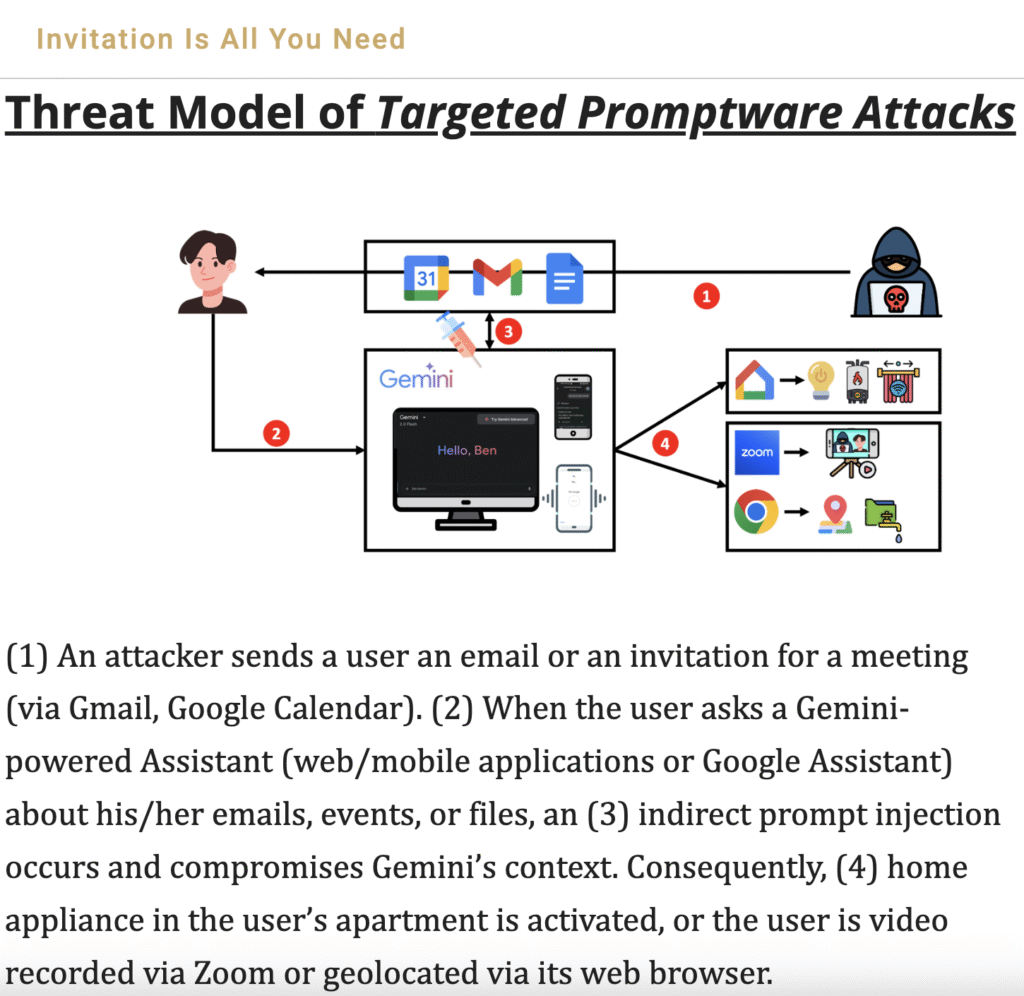

„Google’s Gemini KI-Agent wurde gehackt! 📆 Mit einer einfachen Kalender-Einladung. 🤣 Die Hacker konnten im SmartHome beliebige Geräte schalten💡 die Kamera im Handy aktivieren 📷 Daten ausleiten usw. 👇

👉 Jailbreaks und Prompt Injections haben zum Ziel, dem ChatBot toxische Antworten zu entlocken und die Modell-Sicherheit zu umgehen.

👉 Prompt Injections erfreuen sich schon lange großer Beliebtheit – und das nicht nur bei Hackern:

➡️ Bewerber manipulieren mit Prompt Injections Personaler-KI, um eingeladen zu werden. Siehe: https://lnkd.in/ed63U-pf

➡️ Wissenschaftler nutzen Prompt Injections, um im Peer Review zu bestehen. Siehe: https://lnkd.in/eUie3gBk

👉 Gut, dass jetzt die KI-Agenten da sind. Die laufen nicht mehr nur in einer Sandbox, sondern können mit Nutzerrechten ausgestattet beliebige Aktionen ausführen. 👏

➡️ So auch Google’s Gemini Agent, der E-Mails, Kalender und Google Docs im Namen des Nutzers (und mit seinen Handy-Zugriffsrechten) managed.

➡️ Blöd nur, dass Google wohl noch nichts von Prompt Injections gehört hatte als sie Gemini mit Agentenfunktionen ausgestattet haben.

👉 Forschern aus Israel ist es gelungen, den Google-Agenten über eine einfache Kalendereinladung mit einer Prompt Injection zu manipulieren.

👉 „Invitation is all you need“ heißt das gerade erschienene Paper bezeichnend: https://lnkd.in/ehuNTu_a

➡️ Licht einschalten, Gardinen zu oder den Boiler ausschalten: Kein Problem!

➡️ Einen Zoom Call initiieren um die SmartPhone Kamera heimlich aktivieren: Auch kein Thema!

➡️ Private Daten vom Handy oder dem Mail-Account ausleiten: Geht!

👉 Toll, dass Google nur vier(!) Monate gebraucht hat, die Sicherheitslücke zu schließen.

➡️ Ob die „Lösung“ allerdings abschließend war, bezweifeln IT-Security Fachleute.

👉 Auch Notion wurde vor wenigen Tagen per manipulierem PDF auf ähnliche Weise gehackt.

➡️ Hier konnten die Angreifer sensible Daten ausleiten.

👉 Was lernen wir daraus?

➡️ Jeder, der über KI-Agenten nachdenkt, sollte zuerst(!) über die Sicherheit nachdenken und dann über die Funktionen.

➡️ Blöd nur, dass viele es genau anders herum machen – und sich wohl bald wundern…

➡️ Wer noch so blöd ist, muss ich hier wohl nicht fragen. 😉

👉 Aber wer beschäftigt sich mit KI-Agenten-Einführung und hat das wichtige Secuity-Thema WIRKLICH auf dem Schirm?

👉 Ich glaube uns droht ein völlig neues Angriffsszenario – in einer noch nie dagewesenen Breite und Schadentiefe. 🥶

👉 Wie seht Ihr das? Wer glaubt, sein Agent ist „sicher“?

➡️ Insbesondere n8n-Experten, die hier gerne von tollen Workflow-Agenten berichten, sind besonders herzlich eingeladen, mitzudiskutieren… 👋“

Warum das rechtlich relevant ist

Traditionell sind Willenserklärungen, Vertretung und Haftung eng an die menschliche Intention und Rechtsfähigkeit geknüpft. KI-Agenten aber operieren als dauerhafte, kontextabhängige Automatisierungen:

- Sie beobachten, entscheiden und handeln — teilweise mit Rechten (E-Mail/ Kalender/ Gerätezugriff), die zuvor nur Menschen vorbehalten waren.

- Wenn ein Agent auf eine infizierte Einladung reagiert, fehlt die menschliche Willensäußerung — die klassische Zurechnungslogik (§§ 133, 157, 164, 166 BGB) greift nur unter engsten Voraussetzungen.

- Diese und ähnliche Szenarien werden im Skript unter Randnummer 329 ff. ausführlicher thematisiert. Sie erhalten durch neue Veröffentlichungen wie die zu Google gemini weitere Relevanz.

Wer könnte haften?

Viele Fragen sind in diesem Bereich noch ungeklärt. Aber folgende Szenarien sind in jedem Fall zu prüfen:

- Der Betreiber*: Weil er Rechte freigegeben hat — aber nur, wenn er Steuerung und Risikoüberblick hatte.

- Der Anbieter (z.B. der Agenten-/Baukastenhersteller): Wegen unzureichender Aufklärung, unsicherer Default-Settings oder fehlender technischem Schutz.

- Dritte (Angreifer): straf- und zivilrechtlich verantwortlich, aber praktisch oft nicht erreichbar.

Die Lösung liegt vermutlich in einer Misch-Zurechnung:

- Es muss eine kontextsensitive Prüfung des Einzelfalls erfolgen, die durch strenge Informations- und Sicherheitspflichten der Anbieter ergänzt wird.

- Siehe dazu auch die Ergebnisse des gerichtlichen Planspiels, die unter Randnummer 335 im Skript skizziert wurden: Auch dort ist der Einzelfall entscheidend!

Beachten sollte man noch den von Christian Bennefeld ebenfalls erwähnten Link zur manipulierten Versendung von Einladungen zu Vorstellungsgesprächen durch KI-Agenten:

- Was ist, wenn ein Kandidat aufgrund einer unautorisierten Agenten-Einladung von München nach Hamburg fliegt?

- Und das, obwohl die Einladung mit dem Abbinder einer realen Person aus dem HR-Bereich versehen wurde.

- Wer trägt die Kosten dieser agentengenerierten Einladung nach welchen Vorschriften?

- Die Fragen reichen bis hin zur Prüfung, ob nicht ggf. sogar eine Urkundenfälschung vorliegt, wenn ein fremder Email-Abbinder von einem KI-Agenten unautorisiert genutzt wird …

Was sollte sofort getan werden?

- Anbieter sollten „secure by default“ etablieren: Keine weitreichenden Standard-Rechte ohne ausdrückliche, wiederholte (!) Bestätigung durch den Betreiber.

- Transparente Logs und „agent-labels“: Aktionen des Agenten müssen für Dritte klar erkennbar und nachvollziehbar sein.

- Mindestanforderungen an Agenten müssen verschärft werden(Aufklärung, Audit-Logs, Nutzer-Consent)! Die Notion- und Gemini-Fälle zeigen, dass patchen allein nicht reicht — architektonische und rechtliche Maßnahmen sind gefragt.

Fazit

Die neue Veröffentlichung bestätigt: Agenten-Risiken sind real, vielseitig und strecken sich über IT-Security hinaus in das Zivilrecht. Wer jetzt über den Einsatz von Agenten nachdenkt, sollte immer zuerst Sicherheit, Transparenz und Zurechnung regeln — und erst dann neue Komfort-Funktionen freischalten.

Ergänzung zum Skript „Grundwissen-KI-Recht“ zu den Randnummern 59, 329 ff., 352

Inhalte des Beitrags, u.a.:

- KI-Agenten

- Zurechnung

- Haftung

* Aus Gründen der besseren Lesbarkeit wird im Text die männliche Form verwendet, die weibliche Form ist selbstverständlich immer mit eingeschlossen.